Insights | 7.12.2023Af Peter Trier Jørgensen

Er du klar over, hvilke skridt din organisation bør tage for at beskytte følsomme oplysninger, når du tager Copilot og andre AI-værktøjer i brug? Det handler ikke kun om at tage din produktivitet til nye højder; det handler om at beskytte dine tophemmelige projekter og fortrolige data.

Nu skal du høre: Uden robuste datasikkerhedskontroller kan Copilot afsløre klassificerede oplysninger som f.eks. lønninger eller værdifulde forretningsoplysninger.

Den gode nyhed? Microsoft Purview har forbedret sig! Nu har vi konkrete datasikkerhedskontroller, der sikrer, at dine oplysninger forbliver sikre i AI-applikationer.

En sej funktion? Copilot respekterer følsomhedsetiketter på de filer, den interagerer med. Så der er ingen grund til at bekymre sig om, at fortrolige oplysninger bliver lækket gennem Copilot, eller at brugere får vist oplysninger, de ikke har adgang til.

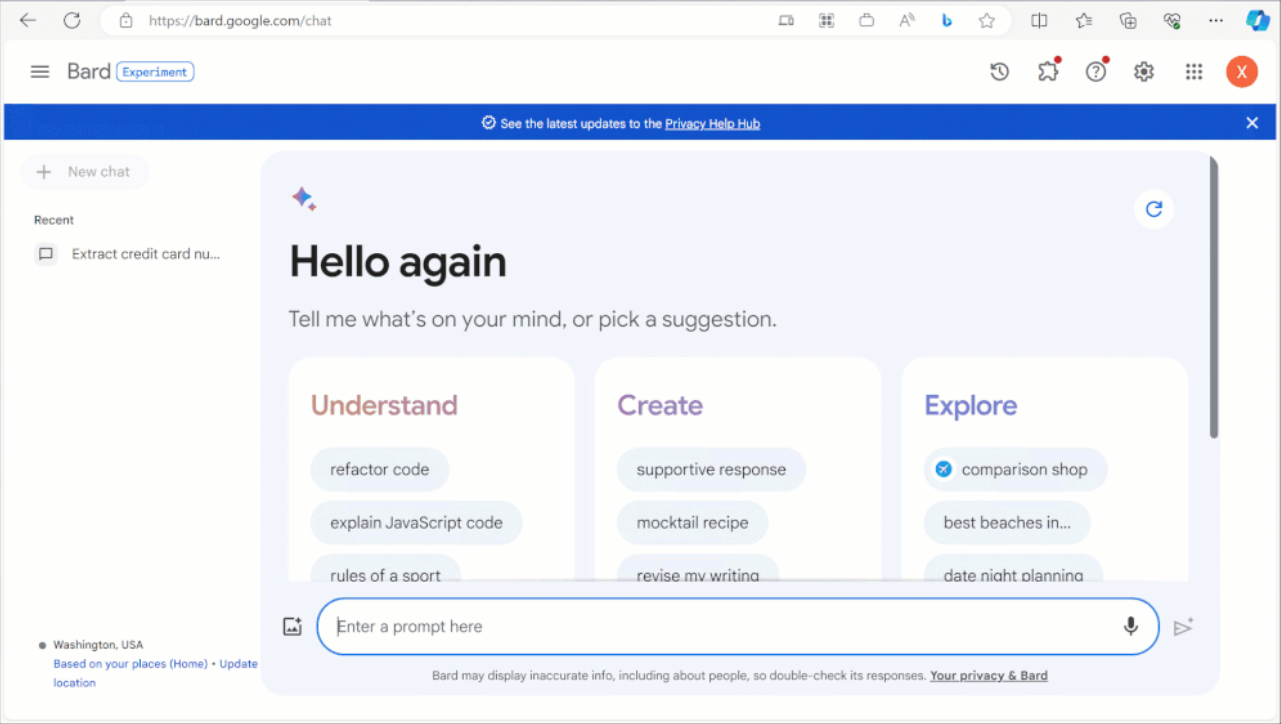

Men det stopper ikke der – beskyttelsen strækker sig ud over Copilot til andre AI-applikationer som ChatGPT, Bard, Bing Chat og meget mere.

Er du nysgerrig efter at vide, hvordan disse kontroller fungerer, og hvordan de kan forbedre din datasikkerhed? Lad os dykke ned i det sammen!

Copilot respekterer følsomhedsmærker

Copilot respekterer følsomhedsmærker på de filer, den henviser til.

Når Copilot interagerer med en mærket fil, får brugerne vist mærket for at informere dem om, at oplysningerne er fortrolige. Brugerne kan nemt identificere fortroligheden og håndtere oplysningerne i overensstemmelse med følsomheden.

Styrk en kultur for sikker brug af data ved at uddanne brugerne i vigtigheden af at beskytte information og håndtere data korrekt. På denne måde ved brugerne, hvad de skal gøre, når Copilot viser dem følsomme data.

- Identificer følsomme oplysninger i dit miljø, og begynd at klassificere og mærke filer og e-mails.

- Uddan brugerne i, hvordan man mærker data og øger bevidstheden om datafortrolighed i AI-applikationer.

Etiketter arves af samtaler og nyt indhold

Når brugere interagerer med Copilot-samtaler, og der henvises til en mærket fil, vil samtalerne arve følsomhedsmærket, inklusive dets beskyttelse. Det betyder, at samtalen vil være tydeligt mærket. Hvis der produceres en ny fil med referencer til en mærket fil, vil den nyligt genererede fil arve etiketten fra den refererede fil, og begrænsninger i adgangsrettigheder vil blive overført.

På den måde behøver brugerne ikke at bekymre sig om, hvorvidt nyoprettet indhold er beskyttet i overensstemmelse hermed, hvilket gør det lettere for dine brugere at beskytte følsomme oplysninger.

- Beskyt data ved at tildele adgangsrettigheder til data, hvor det er relevant. Følsomhedsetiketter giver brugervenlig støtte til dette direkte i Office-applikationer.

- Gennemgå dataplaceringer som SharePoint Online for at sikre, at websteder og mapper er begrænset til de rette brugere.

Beskyttelse ud over Copilot

Datasikkerhedskontrollen strækker sig ud over Copilot og Microsoft 365 til AI-applikationer som ChatGPT, Bard, Bing Chat og meget mere.

Insider Risk Management identificerer risikabel adfærd som f.eks. datalækage til AI-applikationer på nettet. Insider Risk Management har nu en indikator for brugere, der surfer på generative AI-sider. Det hjælper sikkerhedsteams med at identificere potentielle risici i forbindelse med brug af AI-applikationer.

Du kan opdage, når brugere kopierer følsomme oplysninger til AI-applikationer som ChatGPT, og blokere dem proaktivt. Med Endpoint Data Loss Prevention kan du forhindre brugere i at kopiere følsomme data til generative AI-applikationer via webbrowsere.

- Definér sikkerhedskrav til data, herunder hvilke data der er følsomme, hvordan de skal beskyttes, og hvor de kan bruges.

- Følg op på disse sikkerhedskrav ved at implementere Data Loss Prevention for teknisk at begrænse strømmen af følsomme data og forhindre datatab.

Synlighed i brugen af AI-applikationer og tilknyttede risici

For Copilot gemmes brugerinteraktioner og tilknyttede hændelser i revisionslogfiler og kan registreres og revideres ved hjælp af Purview Audit.

Prompts og svar med Copilot bevares og kan søges og findes med Content Search og eDiscovery.

Purview AI Hub giver overblik over, hvordan brugerne bruger Copilot og over 100 andre AI-applikationer.

Du vil være i stand til at identificere, hvilke AI-applikationer brugerne beder om, hvordan de bruger dem, og hvilke specifikke følsomme oplysninger der indgår i beskederne.

Microsoft Defender for Cloud Apps tilføjer over 400 generative AI-applikationer til cloud-app-kataloget, så du kan få indsigt i brugen af disse og godkende eller blokere brugere fra at bruge applikationerne.

- Overvågning og auditering bør være en integreret del af din datasikkerhed, og dit sikkerhedsteam bør reagere på advarsler eller risikabel adfærd. Brug de integrerede funktioner i Microsoft Purview til at automatisere så meget som muligt og fokusere på de vigtige aktiviteter.

- Forbedr løbende din indsats for datasikkerhed og compliance.